04 中国大脑计划:自下而上的超级工程(第3/7页)

2011年,百度在语言识别领域起步,到了2016年,百度语音识别技术的准确率已达97%。

2012—2016年的4年里,百度语音识别的准确度提升了近30%。即便是有严重地方口音的普通话,每100句中百度语音也能毫无差错地识别出85句。按照可以听错一个字的标准来计算,百度语音则可以准确识别出98句,而未经训练的普通人只能听懂60句。这个识别体系要做到方言识别,需要至少720小时的语料用于训练,从声音、内容到说话者,都要不断变化以提升系统的敏感度。

要让百度大脑“说人话”更是一件很有难度的事情。百度则是运用声学模型和语言模型。声学模型决定了语言的发音。打出一个字,系统就在原始音库中找到合适的发音对应上去。要让电子发音没有机器味而有“人味”,就要为语音资料建库。例如让机器学习时间从20小时升到100小时,此后机器模仿出来的声音听起来就舒服多了。为了保持语音的连贯性,不至于让合成语音听起来像“断气”了一样,百度大脑语言模型还会持续提升文本库的学习连接概率。比如说出“中华”,系统还能在后续词组中选择“人民共和国”“民族”“儿女”等进行匹配。

长语音是让机器语音更有气场的技术。情感合成、远场方案、长语音方案等能为合成语音加入情感,让其更接近真人发声效果。

语音识别的场景应用极为广泛。比如我们可以借此创造出一个“最强销售员”:销售员新手给客户打电话时,百度大脑实时记录客户的回复,并显示在电脑屏幕上,系统可以瞬时搜索并调取优秀销售员以往对这些问题给出的回复。这样,每个“菜鸟”只要“照本宣科”,就能在上岗第一天掌握过去最优秀的销售员所具备的交流能力。另外,2014年,百度为特斯拉汽车提供智能语音方案,中国车主可以使用语音控制车载娱乐系统、指挥地图导航、发起搜索,甚至通过蓝牙拨打电话。

随着语音识别而来的还有对语音特征的抓取。例如在胡歌朗读《青玉案·元夕》的上阕后,语音识别系统可以自动生成下阕。对于一些语音有特点的明星声音,目前只需录制和分析大约2000句,系统就能合成他们的声音。

目前,百度每天响应的语音合成请求达到了2.5亿次。在情感语音合成技术上线后,用语音听小说的百度用户每日停留时长从过去的0.69小时增加到现在的2.21小时。未来,这一功能除了“读小说”还将给予人们情感慰藉。当家里老人和孩子想念忙碌的家人时,可以随时有“他们”的声音陪伴。

百度基于神经网络翻译模型技术的机器翻译系统正在快速学习各类语言。经过6年的积累,如今的百度翻译已经可以支持全球28种热门语言互译,覆盖756个翻译方向。百度语音可以支持粤语、沪语等方言的识别。

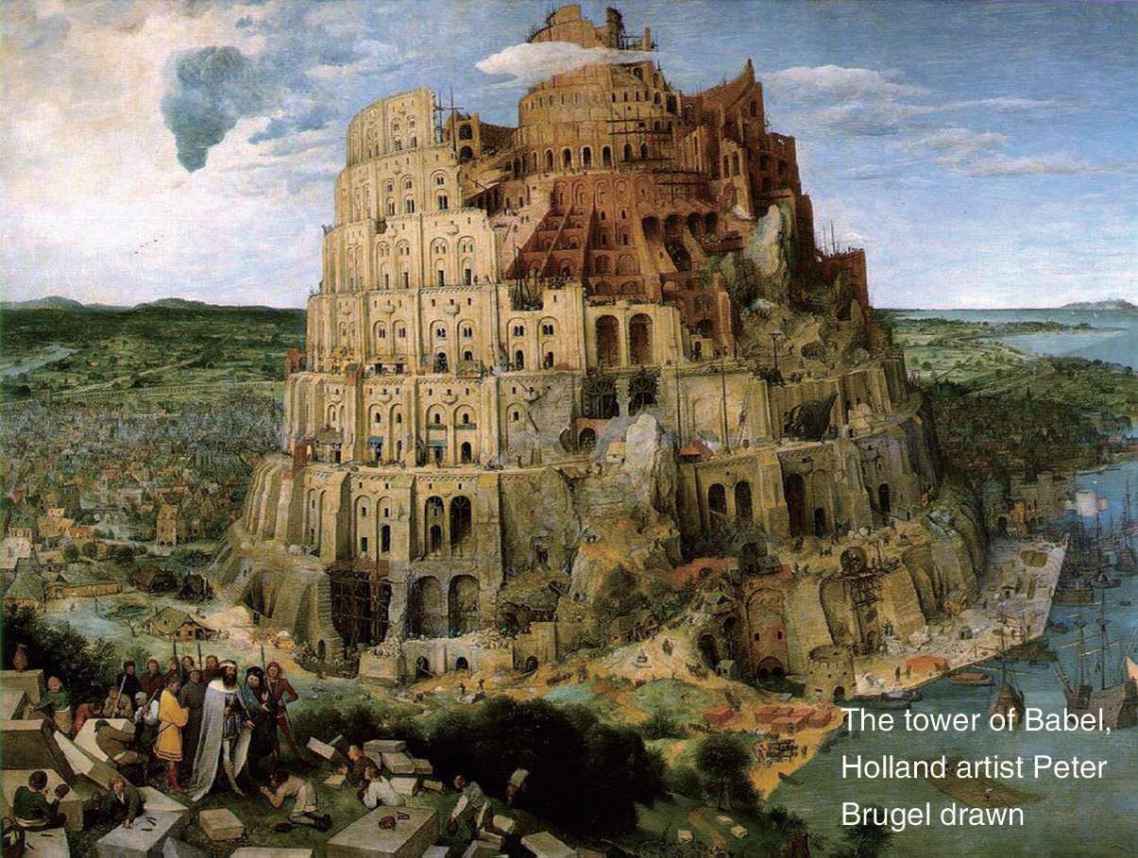

上帝曾伸手割裂了人类的语言统一,让四面八方的人由于语言不同而无法沟通。有了机器翻译,人类终于可以携起手来,建造出一座真正的巴别塔[1]。

图4-2 荷兰画家彼得·勃鲁盖尔绘制的巴别塔

注:使用手机百度或智能革命App扫描图片可见AR效果。

百度大脑的好视力

“视觉”承担着我们80%的信息摄入工作。在解决“听”“说”问题的同时,我们也要教会计算机“看”,即图像识别。以识别一朵花为例,用户将图片上传百度后,百度大脑将它转化成“0101”的数字流,然后输入深度神经网络,经过层层分析、层层抽象,对包括像素在内的各层信息与现有的大数据进行比对,才能重新还原并识别出它是一朵花。这种方法其实和人类眼睛的功能是近似的。

这一切都要建立在预先对图片做出分类的基础上。目前世界上最大的图像识别数据库ImageNet的图片分类有1000多类。而百度图片数据库的分类则已经达到4万类。

百度正在从四个方面推进计算机视觉计划。首先是人脸识别,通过捕捉人脸关键点形成人脸表情网,实现人脸的准确识别;其次是在类似百度地图的产品中,实现地图服务与图像智能识别技术的结合,打造数据无限逼近现实世界的效果;此外,百度无人驾驶技术也正在利用计算机视觉进行程序优化,从而使无人车的研发速度加快;图像识别还会被应用于AR(增强现实)领域提高视觉效果。

百度的人脸识别已经远远超过人类,百度资料库中有超过2亿张人脸照片,浏览识别训练量超过200万张。目前,百度大脑能够自动确定图片中人脸的数目及每张人脸的位置和大小,并支持正面、侧面多个角度。即使目标在运动中也不会降低甄别率。系统通过定位眼睛、眉毛、鼻子、嘴巴、脸颊轮廓等70多个关键点位置,能够进行像素级人脸解析,并根据人脸图像识别人的性别、年龄、表情、姿态等属性。