01 简史:互联网风云背后的人工智能生长(第3/11页)

过去百度从不专门成立研究机构,我们的工程师就是研究人员,研究始终与实际应用结合得非常紧密,但是我认为,深度学习会在未来很多领域产生巨大影响,而那些领域并不都是百度现有业务范围之内的。所以,有必要创造一个专门的空间,把人才吸引进来,让他们能够自由发挥,去尝试各种各样的创新,在百度过去可能从来没有接触过的领域做研究,为全人类的人工智能革命探索道路。

“智能”已换代

如果人工智能的启蒙阶段可以称为1.0时代的话,那么现在很明显已经大步进入2.0时代了,机器翻译就是典型案例。过去的机器翻译方法就是基于词和语法规则进行翻译——人类不断地把语法规则总结出来告诉机器,但却怎么也赶不上人类语言尤其是语境的多变,所以机器翻译总是会出现诸如把“how old are you”翻译成“怎么老是你”的笑话。

后来出现了SMT(统计机器翻译),基本思想是通过对大量的平行语料进行统计分析,找出常见的词汇组合规则,尽量避免奇怪的短语组合。SMT已经具有机器学习的基本功能,有训练及解码两个阶段:训练阶段就是通过数据统计让计算机构建统计翻译模型,进而使用此模型进行翻译;解码阶段就是利用所估计的参数和给定的优化目标,获取待翻译语句的最佳翻译结果。

SMT研究在整个业界已经持续了二十多年,对于短语或者较短的句子,翻译效果显著,但是对于较长的句子翻译效果就一般了,尤其是对语言结构差异较大的语言,例如中文和英文。直到近几年NMT(基于神经网络的翻译)方法崛起。NMT的核心是一个拥有无数结点(神经元)的深度神经网络,一种语言的句子被向量化之后,在网络中层层传递,转化为计算机可以“理解”的表达形式,再经过多层复杂的传导运算,生成另一种语言的译文。

但是应用这个模型的前提是数据量要大,否则这样的系统也是无用的。像百度和谷歌这样的搜索引擎,可以从互联网上发现和收集海量的人类翻译成果,把如此巨大的数据“喂给”NMT系统,NMT系统就可以训练和调试出比较准确的翻译机制,效果要好于SMT。中文和英文之间的双语语料信息储备越多,NMT的效果就越好。

SMT以前用的都是局部信息,处理单位是句子切开以后的短语,最后解码时将几个短语的译文拼接在一起,并没有充分利用全局信息。NMT则利用了全局信息,首先将整个句子的信息进行编码(类似人在翻译时通读全句),然后才根据编码信息产生译文。这就是它的优势,也是其在流畅性上更胜一筹的原因。

比如,翻译中有一个很重要部分是“语序调整”。中文会把所有的定语都放在中心词前面,英文则会把修饰中心词的介词短语放在后面,机器常混淆这个顺序。NMT在语序学习上的优势带来了它翻译的流畅性,尤其在长句翻译上有明显优势。

传统的翻译方法也不是一无是处,每一种方法都有其擅长的地方。以成语翻译为例,很多时候有约定俗成的译文,不是直译而是意译,必须在语料库中有对应内容才能翻译出来。如今互联网用户的需求是多种多样的,翻译涉及口语、简历、新闻等诸多领域,一种方法很难满足所有的需求。因此百度一直把传统的方法如基于规则的、基于实例的、基于统计的方法与NMT结合起来向前推进研究。

在这种机器翻译的模式中,人类要做的不是亲自寻找浩繁的语言规则,而是设定数学方法,调试参数,帮助计算机网络自己寻找规则。人类只要输入一种语言,就会输出另一种语言,不用考虑中间经过了怎样的处理,这就叫作端到端的翻译。这种方法听起来挺神奇,其实概率论里的贝叶斯方法、隐马尔科夫模型等都可以用来解决这个问题。

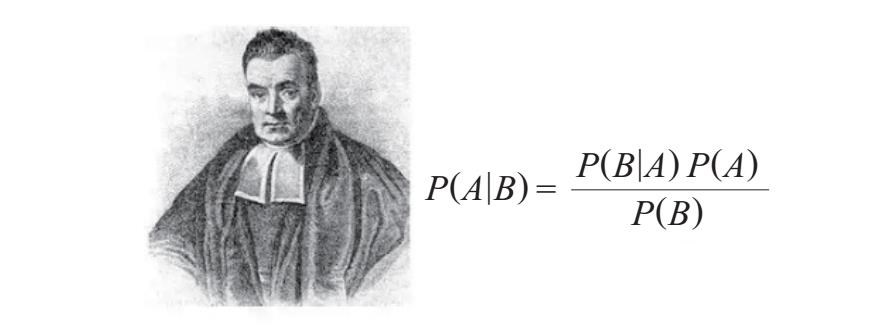

以资讯分发当中的贝叶斯方法为例,可以构建一个用概率来描述的人格特征模型。比如男性读者模型的特征之一是在阅读新闻时点击军事新闻的概率是40%,而女性读者模型是4%。一旦一个读者点击了军事新闻,根据图1-2中的贝叶斯公式就可以逆推这个读者的性别概率,加上这个读者的其他行为数据,综合计算,就能比较准确地判断读者的性别以及其他特征。这就是数学的“神奇”。当然,计算机神经网络使用的数学方法远不止这些。

图1-2 贝叶斯与贝叶斯公式[1]

类似机器翻译的人工智能技术方法的前提是数据量足够大。互联网提供了以前科学家梦寐以求却难以得到的海量数据。互联网诞生的初衷是为了信息沟通方便,结果带来了信息爆炸,信息爆炸又促进了人工智能技术的发展。